Desde una victoria contra los mejores jugadores humanos de Go, por ejemplo, hasta, más recientemente, el pronóstico del tiempo con una precisión sin precedentes, los avances en IA continúan sorprendiendo. Un resultado aún más desconcertante es la generación de imágenes sorprendentemente realistas, que alimentan cierta confusión entre lo verdadero y lo falso. Pero ¿cómo se generan automáticamente estas imágenes?

Los modelos de generación de imágenes se basan en el aprendizaje profundo, es decir, redes neuronales muy grandes que pueden alcanzar varios miles de millones de parámetros. Una red neuronal puede considerarse como una función que asociará datos de entrada con predicciones de salida. Esta función está compuesta por un conjunto de parámetros (valores numéricos) inicialmente aleatorios que la red aprenderá a fijar mediante el aprendizaje.

Para dar un orden de magnitud, el modelo de Difusión Estable , capaz de generar imágenes realistas, está compuesto por 8 mil millones de parámetros y su entrenamiento costó 600.000 dólares.

Estos parámetros deben aprenderse. Para explicar su aprendizaje, podemos considerar el caso más simple de detectar objetos a partir de imágenes. Se presenta una imagen como entrada a la red y la red debe predecir posibles etiquetas de objetos (automóvil, persona, gato, etc.) como salida.

El aprendizaje consiste entonces en encontrar una buena combinación de parámetros que permita la predicción más correcta posible de los objetos presentes en las imágenes. La calidad del aprendizaje dependerá principalmente de la cantidad de datos etiquetados, el tamaño de los modelos y la potencia de cálculo disponible.

En el caso de la generación de imágenes, es de alguna manera el proceso inverso el que queremos hacer: a partir de un texto que describe una escena, se espera que la salida del modelo cree una imagen correspondiente a esta descripción, lo que es considerablemente más complejo que predecir una etiqueta.

Destruir para crear

Primero, olvidémonos del texto y centrémonos únicamente en la imagen. Si generar una imagen es un proceso complejo incluso para un ser humano, destruir una imagen (el problema inverso) es un problema trivial. Concretamente, a partir de una imagen compuesta de píxeles, cambiar el color de ciertos píxeles de forma aleatoria constituye un método sencillo de alteración.

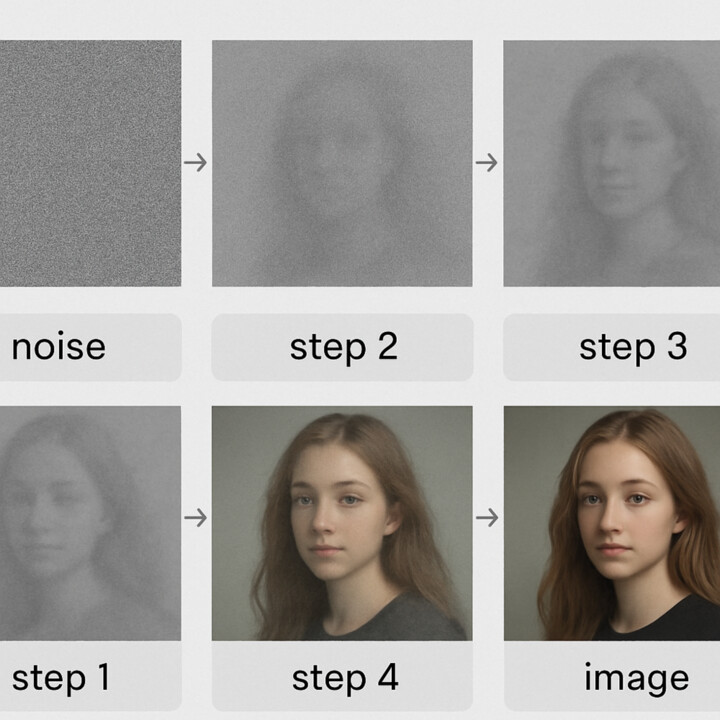

Podemos presentar una red neuronal con una imagen ligeramente alterada como entrada y pedirle que prediga la imagen original como salida. Luego podemos entrenar al modelo para que aprenda a eliminar el ruido de las imágenes, lo que constituye un primer paso hacia la generación de imágenes. Así, si partimos de una imagen muy ruidosa y repetimos la llamada del modelo secuencialmente, obtendremos en cada llamada una imagen cada vez menos ruidosa hasta obtener una imagen completamente denozada.

Si exageramos el proceso, podríamos entonces empezar con una imagen compuesta enteramente de ruido (una nieve de píxeles aleatorios), en otras palabras una imagen de nada, y repetir las llamadas a nuestro modelo "denoiser" para terminar con una imagen como la que se muestra a continuación:

Tenemos entonces un proceso capaz de generar imágenes pero de interés limitado porque, dependiendo del ruido aleatorio, puede después de varias iteraciones acabar generando cualquier cosa como imagen de salida. Por lo tanto, necesitamos un método para guiar el proceso de eliminación de ruido y se utilizará texto para esta tarea.

Del ruido a la imagen

Para el proceso de eliminación de ruido necesitamos imágenes, estas provienen de internet y nos permiten constituir el conjunto de datos de entrenamiento. Para el texto necesario para guiar la eliminación de ruido, simplemente se utilizan los títulos de las imágenes que se encuentran en Internet. Junto con el aprendizaje de la eliminación de ruido de la imagen, se asocia una red que representa el texto. Entonces, cuando el modelo aprende a eliminar el ruido de una imagen, también aprende con qué palabras se asocia esa eliminación. Una vez finalizado el entrenamiento, obtenemos un modelo que, a partir de un texto descriptivo y ruido total, irá mediante sucesivas iteraciones eliminando el ruido para convergir hacia una imagen que coincida con la descripción textual.

El proceso elimina la necesidad de etiquetado manual específico. Se alimenta de los millones de imágenes asociadas a sus títulos ya presentes en la web. Finalmente, una imagen vale más que mil palabras, a modo de ejemplo, la imagen de arriba se genera a partir del siguiente texto: "flores de huevo frito en el jardín de tocino" mediante el modelo de Difusión Estable. ![]()

Christophe Rodrigues , profesor-investigador en informática, Pôle Léonard de Vinci

Este artículo se vuelve a publicar de The Conversation bajo una licencia Creative Commons. Lea el artículo original .